NTT コミュニケーション科学基礎研究所は、当研究所の最新の研究成果を体感し身近に感じてもらうため、「NTT コミュニケーション科学基礎研究所 オープンハウス2023」を、6月1~2日にNTT西日本オープンイノベーション施設QUINTBRIDGEにて開催する。会場ではデモ展示、ポスターなどを通じて、研究者自らが研究成果を分かりやすく紹介する。またオープンハウス当日には、特設ウェブサイトも公開され、その後一定期間、招待講演・所長講演・研究講演・展示内容など、各種動画コンテンツ(事前録画)が視聴できる予定だ。入場は無料だが事前登録が必要となる。

本イベント開催に先がけ、5月29日にはNTT本社にて内覧会が行われた。内覧会ではまずNTT コミュニケーション科学基礎研究所の所長である納谷太氏が登壇し、NTT R&Dの体制についてや、研究所のミッションと研究領域について説明が行われた。『人間科学』、『メディア処理』、『多用脳科学』、『データと機械学習』の4つに分野について研究を行い、『人間を深く理解し究めること』、『人間の能力に迫り凌駕すること』を目指しているとのこと。ただし、ただ研究成果を出すということではなく、『心まで伝わるコミュニケーションの実現』というキーワードがポイントだということもアピールしていた。

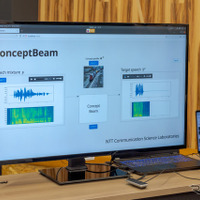

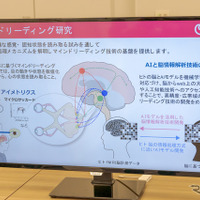

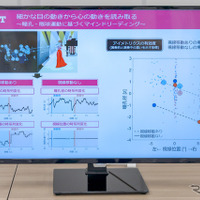

展示物については、最新の成果16案件から厳選したものを展示。『興味のある話題に聞き耳を立てる ~意味で音声を分離抽出する新しい信号処理技術ConceptBeam~』、『生徒それぞれに適度なレベルの問題を出題します ~Monotonic VAEに基づいた個別最適な問題推薦手法~』、『細かな目の動きから心の動きを読み取る ~瞳孔・眼球運動に基づくマインドリーディング~』、『マグネシェイプ:磁気作動式ピンディスプレイ』、『離れていても柔らかく触れる? ~遠隔操作ロボットにおける高追従低剛性制御の実現~』の5つが公開されていた。

発表された5つの技術の中で、クルマ社会に生かせそうなConceptBeamと瞳孔・眼球運動に基づくマインドリーディングについて説明を受けつつ、担当者にお話をうかがってきた。

◆どんな音を分離するかはクルマメーカーのサジ加減となる

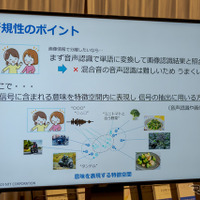

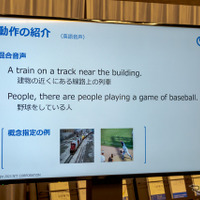

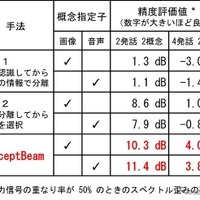

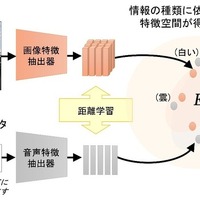

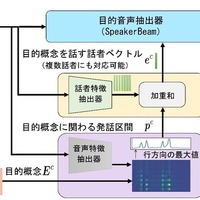

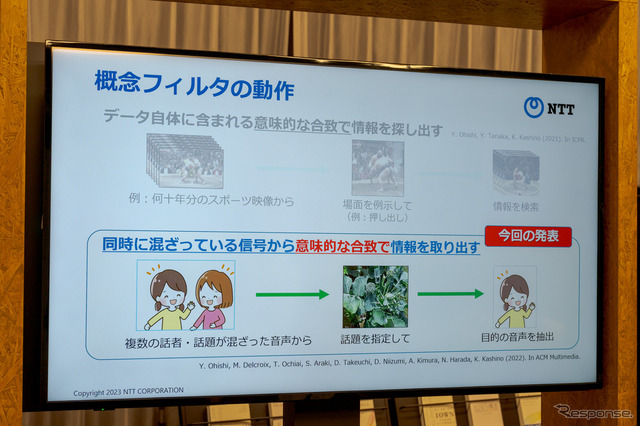

『興味のある話題に聞き耳を立てる ~意味で音声を分離抽出する新しい信号処理技術ConceptBeam~』は、複数の話者や話題が混在した音声信号から、画像や音声などで指定した意味に適合する音声信号だけを分離抽出する技術。複数の音声が混在した信号から、話されている内容に基づいて目的の音声を取り出すことができる世界初の技術とのこと。

従来の方法ですぐに思いつくのは、各話者の音声認識を行ない、片方の話者だけの音声を取り出すというもの。しかしこの方法では同時にふたりがしゃべっていると音声認識の精度が下がり、ひとりの話者だけの音声を抽出することは困難を極める。

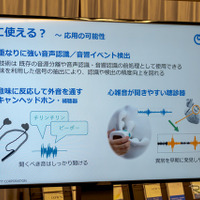

しかし今回発表の技術では、特徴空間というものを作り、信号に含まれる意味を特徴空間に表現し、その概念から取り出したい信号だけをピックアップするという方法とのこと。この技術を使えば、音声認識の前段階の処理として仕様できたり、音の意味に反応して外音を通すノイズキャンセリングヘッドホンや補聴器などへの応用が考えられる。また心雑音が聞きやすい補聴器なども作り出せるのではないかと説明された。

たとえば、車内静音化の進んだクルマで、緊急車両や踏み切りの警報音など、走行時に重要な音だけを車内に聞こえるような技術として使えるか聞いてみたところ、技術的にはできると思うとのことだった。ただし、どの音を拾うのかは各自動車メーカーのチューニングによって変わり、必要な音の取捨選択となるので、実証実験が必要だと思われる。

デモとしてふたりの会話からひとりの会話を取り出しと、4人の会話からふたつの会話の取り出しが実現していたが、人数が倍に増えると3分の1から4分の1ほどの成功精度になる。精度的にはまだまだ改良する必要がありそうだが、多種の情報に対して興味のある情報を高速かつ的確に特定し、取り出し、活用できるというのはこれからの社会では重要な技術となりそうだ。

◆瞳孔・眼球運動を見ればどこに注力しているかわかる

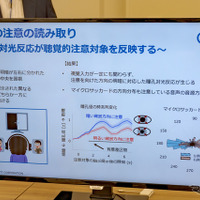

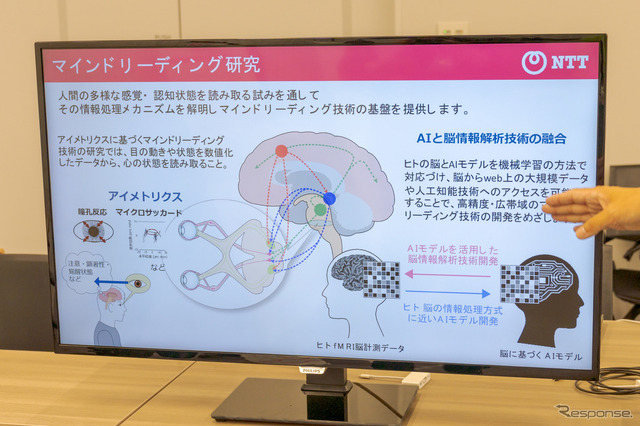

『瞳孔・眼球運動に基づくマインドリーディング』については体験型のデモ展示となっていた。従来、人が何に注意を向けているかは、大きな視線の移動の変化などを伴う視覚情報を基にするものがほとんどだった。

しかし本研究ではまず、聴覚的な注意の状況と、目の細かな動きとの関係を検討。その結果、大きな視線の動きがない場合でも、どの音声に関心を寄せているかといった聴覚的注意の状況が、目の無意識な動きに反映されることを確認。この事は、視覚に加えて聴覚に関しても、人の興味や注意等の認知状態が目の動きの測定データから読み取れる可能性を示している。目の動きは、その人の心の状態を反映しているため、注意の対象、覚醒状態、感情や情動といった心の状態を、その人の目の動きの測定データから読み取ろうとする研究が、さまざまな研究機関で進められている。

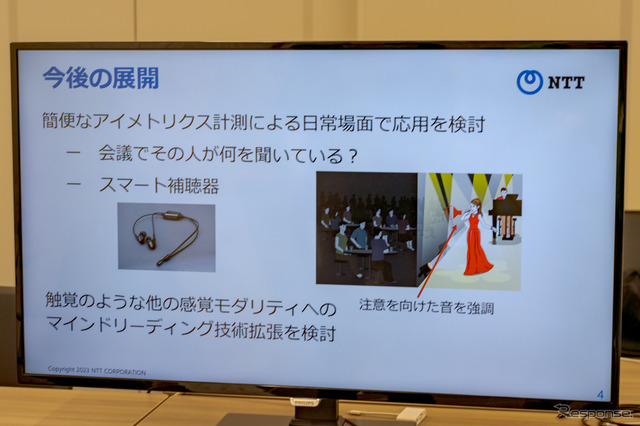

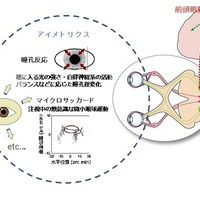

今回のデモでは、異なる場所の複数の音源からの聴覚情報に対する注意の向きを、瞳孔径の変化から読み取れる可能性を明らかにしている。

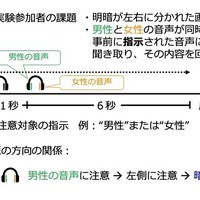

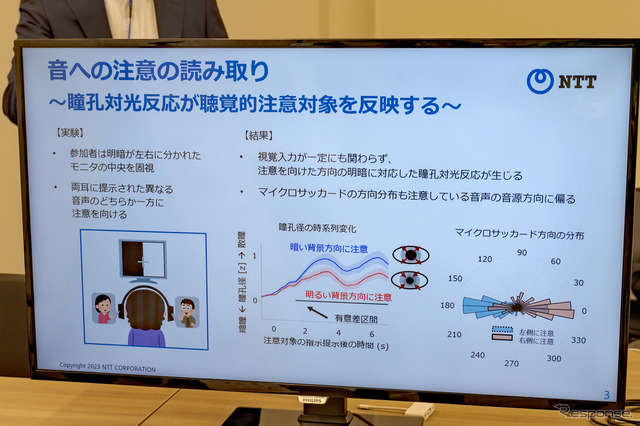

実験では左右で明るさの違う図形(背景)を提示し、目を動かさずに、左右の領域の間にある灰色の中央の領域を見続けるような状況を設定。この状況で、ふたつの音声(聴覚刺激)を参加者の装着したヘッドホンの左右のチャンネルから同時に提示し、ふたつの音声のどちらかに注意を向けるように指示を行う。

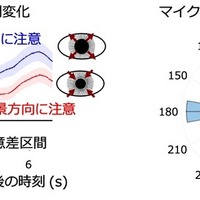

この状態で、明るい背景領域が提示されていた方向のチャンネルに流れていた音声に注意を向けていた場合と、暗い背景の方向の音声に注意を向けていた場合の、ふたつの条件間で繰り返し測定した実験参加者の瞳孔径を比較。その結果、暗い背景の方向から流れる音声に注意した条件の方が、明るい背景の音声に注意した条件よりも、瞳孔径の平均値が大きくなった。さらに、瞳孔径だけではなく、固視中に観察される微小な眼球運動であるマイクロサッカードの方向分布も注意している音声の音源方向に偏ることが明らかとなる。つまり、聴覚的注意がどこを向いているかは、瞳孔反応やマイクロサッカードから推定できるということがわかった。

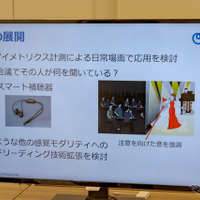

この実験は、顔を固定して瞳孔をしっかりと読み取れるセンサーを使用して行っているが、最近では顔を固定せず、メガネタイプの計測機器で瞳孔をチェックすることもできるとのこと。機器の価格も10分の1程度と低価格とのことだが、精度は劣るため、今回の実験のような微小な眼球運動の様子を捉えるのは難しいという話だった。

◆注意するポイントを見逃すとアラートを表示するクルマへの応用は?

たとえば、クルマのドライバーがどこに注意を向けているかをセンサーが読み取り、注力しなければならないところを見逃しそうな場合、アラートを表示するようなシステムを開発できるかを担当者に聞いた。

もしクルマで利用するとなれば、メガネタイプのセンサーを利用するしかないが、現状のセンサーでは精度の問題で実現は難しいだろうとのこと。またセンサー精度が上がったとしたら可能にはなるだろうが、クルマの運転となると、生死を分けるような判断もあるかもしれない。そういった事例を予測し、自動車メーカーがどれだけの実証実験を行ない、どういった使いかたをするのかは慎重に判断すべきだろうと語ってくれた。

NTT研究所としては今後、簡便な計測を可能にする機器環境の提案や、これらの実用化に必要な応用研究へも取り組むことで、無意識的で言語的には表現しづらい心の内側をも考慮した豊かなコミュニケーション技術の実現をめざすとしている。